Новости первого дня gpu technology conference 2015 — часть 3 из 3

Отечественный обозреватель завершает рассказ о первом дне GPU Technology Conference 2015, начатый в первой и продолженный во второй новостях на эту тему.

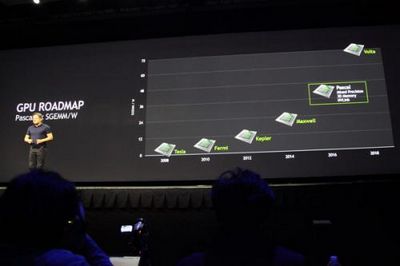

Глава Nvidia поведал на GTC и о новом поколении графической архитектуры — Pascal. Ничего особенно нового о ней мы не услышали, а о самом существовании было в далеком прошлом известно. Pascal — это следующая архитектура GPU компании, которая ожидается к выходу в 2016 году.

Не считая всего другого, от новинки ожидают до 10-кратного повышения производительности в задачах deep learning, если сравнивать с текущими чипами Maxwell.

По ходу собственного выступления Дженсен раскрыл кое-какие подробности Pascal и продемонстрировал обновленный замысел по выпуску графических ответов в ближайщее время, выразив надежду, что новая архитектура по окончании более чем трёхлетней разработки покажет себя с хорошей стороны. Так как главной темой нынешней GTC есть deep learning (применение самообучающихся нейросетей), то поведали о том, как это сказалось на дизайне Pascal, объявленном на прошедшей конференции.

Графические решенияя Pascal будут иметь три главных преимущества, которые связаны с подобным применением, что позовёт более правильное и стремительное обучение сложных и глубоких нейросетей. Вместе с большим количеством памяти в 32 гигабайта (что практически в три раза больше, чем у объявленного только что Titan X), выделяется ещё одно новшество — семь дней поддерживает вычисления смешанной точности.

Кроме этого в GPU следующей архитектуры будет использоваться память с объемной компоновкой (stacked DRAM), которая в пять раз стремительнее в приложениях deep learning. Кроме этого нужно не забывать и о помощи скоростных внутренних соединений NVLink, объединяющих два либо более GPU. Всё совместно это в следствии должно дать 10-кратный прирост в указанных задачах.

Вычисления смешанной точности в Pascal употребляются для двойного ускорения расчётов, которым достаточно 16-битной «половинной» точности вычислений — они в два раза стремительнее, чем привычные FP32 (одинарная точность). Увеличенная производительность таких вычислений даст свёртки скорости и прирост классификации (convolution) — двух ответственных шагах deep learning, при сохранении достаточной точности вычислений.

Использование памяти с объемной компоновкой разрешит расширить скорость доступа к данным и в один момент повысить энергетическую эффективность. Это крайне важно, поскольку как раз ограничения ПСП обычно определяют и конечную скорость сложных параллельных расчётов, и внедрение 3D-памяти обеспечит трёхкратный рост ПСП при таком же повышении количества буфера кадра (количества видеопамяти) — это разрешит исследователям строить нейросети большего размера и ускорить кое-какие из частей тренировки машинного метода при глубоком обучении.

Как уже было известно, графические процессоры архитектуры Pascal будут иметь микросхемы памяти поставленные друг на друга и на GPU, вместо того, дабы быть размещёнными на печатной плате. Уменьшение длины проводников между чипами памяти и GPU приведет к энергетической эффективности и повышению быстродействия.

Добавление помощи скоростного соединения NVLink к Pascal ускорит перемещение данных между GPU и CPU в 5-12 раз, если сравнивать с передачей данных и сейчас применяемой шине PCI Express, что кроме этого серьёзно ускорит приложения deep learning, требующие стремительного сообщения между графическими процессорами. Это особенно принципиально важно для глубокого обучения, поскольку одно лишь появление NVLink разрешит в два раза расширить количество GPU в совокупности, в один момент трудящихся над одной и той же задачей deep learning.

Источник: Личный обозреватель iXBT на GPU Technology Conference 2015